atuin mittels /bin/bash?

Ich wurde über Mastodon auf das Tool atuin aufmerksam - aber als ich mit die Beschreibung des Repository durchlas dachte ich, dass das doch auch ohne Rust funktionieren muss...

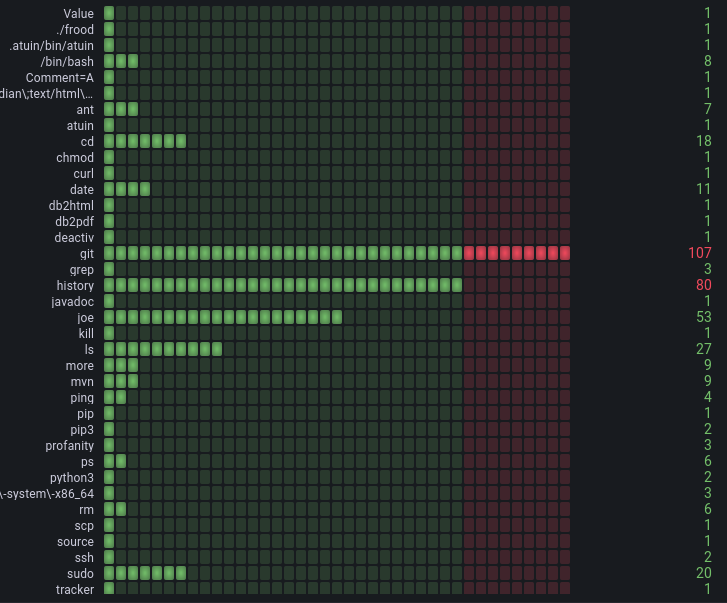

Der Screenshot zeigt die Häufigkeit benutzter Kommandos in der (zum Beispiel) Bash - filterbar nach diversen Gesichtspunkten.

Also versuchte ich zunächst mittels ganz normaler Kommandozeilenlogik die Häufigkeit benutzter Kommandos mittels history und ein paar anderer Kommandos zu ermitteln - das Ergebnis war:

history|tr -s ' '|cut -d ' ' -f 5|sort|uniq -c|tr -s ' '|sort -r -n -t' ' -k1|more

Achtung: Voraussetzung ist, die Umgebungsvariable $HISTTIMEFORMAT entsprechend korrekt zu setzen, also zum Beispiel HISTTIMEFORMAT="%F %T" bei mir.

Das Ergebnis könnte zum Beispiel so aussehen (die ersten 5 Zeilen):

2376 git

562 cd

274 joe

210 ls

69 ping

Das ist schon ganz ok - aber man kann hier noch nicht filtern: es wird immer die gesamte History benutzt und Vergleiche - zum Beispiel zwischen diesem und dem Vormonat sind so nicht möglich. Aber Moment mal - gab es da nicht schon etwas Fertiges? Genau! Influxdb im Zusammenspiel mit Grafana!

Dazu müssten die Daten aber erst einmal in Influxdb hineinwandern. Glücklicherweise bietet Influxdb dafür eine einfache HTTP-Schnittstelle an - Daten, die im Lineprotocol formatiert sind lassen sich so sehr einfach - etwa mit wget oder curl in eine Influxdb-Instanz hochladen.

Und so kam ich zu folgendem Script, das eine Zeile der History verarbeitet und an Influxdb hochlädt (wenn man den Hostnamen und Port der URL korrekt anpasst):

#!/bin/bash

#https://stackoverflow.com/questions/296536/how-to-urlencode-data-for-curl-command

rawurlencode() {

local string="${1}"

local strlen=${#string}

local encoded=""

local pos c o

for (( pos=0 ; pos<strlen ; pos++ )); do

c=${string:$pos:1}

case "$c" in

[-_.~a-zA-Z0-9] ) o="${c}" ;;

* ) printf -v o '%%%02x' "'$c"

esac

encoded+="${o}"

done

echo "${encoded}" # You can either set a return variable (FASTER)

REPLY="${encoded}" #+or echo the result (EASIER)... or both... :p

}

lineformatencode() {

local string="${1}"

local strlen=${#string}

local encoded=""

local pos c o

for (( pos=0 ; pos<strlen ; pos++ )); do

c=${string:$pos:1}

case "$c" in

[+\Q/\E-_.~a-zA-Z0-9] ) o="$c" ;;

* ) o="\\$c"

esac

encoded+="${o}"

done

echo "${encoded}" # You can either set a return variable (FASTER)

REPLY="${encoded}" #+or echo the result (EASIER)... or both... :p

}

while IFS= read -r line

do

timestamp=$(date --date="$(echo -n "$line"|tr -s ' '|cut -d ' ' -f 3,4|tail -n 1)" "+%s%N")

parameters=$(echo -n "$line"|tr -s ' '|sed 's/|/ /'|cut -d ' ' -f 6-)

commandline=$(echo -n "$line"|tr -s ' '|cut -d ' ' -f 5-)

command=$(echo -n "$line"|tr -s ' '|sed 's/|/ /'|cut -d ' ' -f 5)

encodedts=$( lineformatencode "$timestamp" )

encodedp=$( lineformatencode "$parameters" )

encodedcl=$( lineformatencode "$commandline" )

encodedc=$( lineformatencode "$command" )

curl -k -i --header 'Private-Token: xxxx-xxxx-xxxxxxxxxx' -XPOST http://<host>:<port>/write?db=monitoring --data-binary "history,command=$encodedc,commandline=$encodedcl,parameters=$encodedp coun

t=1 $encodedts"

done <"${1:-/proc/$$/fd/0}"

Es nimmt seinen Input aus stdin und kann zum Beispiel so angewendet werden (das measurement ist immer 1 und es werden für jeden History-Eintrag 3 Tags gespeichert:

- command

- commandline

- parameters

history|./send_history_to_influx_4_grafana.sh

Und wenn man die Daten in Influxdb gespeichert hat, kann man eine entsprechende Auswertung durchführen- etwa mittels eines solchen Panels:

{

"id": 2,

"gridPos": {

"h": 25,

"w": 17,

"x": 0,

"y": 0

},

"type": "bargauge",

"title": "Panel Title",

"datasource": {

"uid": "000000001",

"type": "influxdb"

},

"fieldConfig": {

"defaults": {

"mappings": [],

"thresholds": {

"mode": "absolute",

"steps": [

{

"value": null,

"color": "green"

},

{

"value": 80,

"color": "red"

}

]

},

"color": {

"mode": "thresholds"

}

},

"overrides": []

},

"options": {

"reduceOptions": {

"values": false,

"calcs": [

"lastNotNull"

],

"fields": ""

},

"orientation": "horizontal",

"displayMode": "lcd",

"showUnfilled": true,

"minVizWidth": 0,

"minVizHeight": 14

},

"targets": [

{

"datasource": {

"uid": "000000001",

"type": "influxdb"

},

"groupBy": [

{

"type": "tag",

"params": [

"command"

]

}

],

"measurement": "history",

"orderByTime": "ASC",

"policy": "default",

"refId": "A",

"resultFormat": "time_series",

"select": [

[

{

"type": "field",

"params": [

"count"

]

},

{

"type": "sum",

"params": []

}

]

],

"tags": [],

"query": "SELECT \"count\" FROM \"history\" GROUP BY \"command\"",

"rawQuery": false,

"alias": "$tag_command"

}

],

"pluginVersion": "9.3.2",

"timeFrom": null,

"timeShift": null

}

Damit kann man dann zum Beispiel eine solche Auswertung erstellen:

Auswertung der Häufigkeit benutzter Kommandos in Grafana

Auswertung der Häufigkeit benutzter Kommandos in Grafana

Vor 5 Jahren hier im Blog

-

Storage Server Konfiguration I

31.01.2021

Ich habe zu Weiterbildungszwecken aus alten PC-Komponenten ein Serversystem zusammengebaut und stelle hier die Konfiguration als Storage-Server vor

Weiterlesen

Tags

Android Basteln C und C++ Chaos Datenbanken Docker dWb+ ESP Wifi Garten Geo Go GUI Gui Hardware Hardware. Links Java Java. Komponenten Jupyter JupyterBinder Komponenten Links Linuc Linux Markdown Markup Music Numerik OpenSource PKI-X.509-CA Präsentationen Python QBrowser Rants Raspi Revisited Security Software-Test sQLshell TeleGrafana Verschiedenes Video Virtualisierung Windows Upcoming...

Neueste Artikel

-

Asymmetrische Kryptographie

Asymmetrische Kryptographie

Ich habe mich mit der Idee schon länger getragen: Nochmal einen Rundumschlag zu asymmetrischer Kryptographie zu machen. Dabei werde ich mich auf Demonstrationen der einzelnen Konzepte und Operationen mit Beispielcode konzentrieren und zu jedem der vorgestellten Konzepte mehr oder weniger ausführlich bezüglich der Einsatzszenarien und Vor- und Nachteile Stellung beziehen

Weiterlesen -

LinkCollections 2026 I

Nach der letzten losen Zusammenstellung (für mich) interessanter Links aus den Tiefen des Internet von 2025 folgt hier gleich die erste für dieses Jahr:

Weiterlesen -

AtTiny85 zur Ansteuerung von OLED-Infodisplays via USB

Ich hatte neulich bemerkt, dass ich bei meinem Wechsel von Github zu Codeberg nicht alle meine Repositories erwischt hatte...

Weiterlesen

Manche nennen es Blog, manche Web-Seite - ich schreibe hier hin und wieder über meine Erlebnisse, Rückschläge und Erleuchtungen bei meinen Hobbies.

Wer daran teilhaben und eventuell sogar davon profitieren möchte, muss damit leben, daß ich hin und wieder kleine Ausflüge in Bereiche mache, die nichts mit IT, Administration oder Softwareentwicklung zu tun haben.

Ich wünsche allen Lesern viel Spaß und hin und wieder einen kleinen AHA!-Effekt...

PS: Meine öffentlichen Codeberg-Repositories findet man hier.